참고영상 : 모두의 딥러닝

뉴런을 수학적으로 만든 모델 Activation Functions

들어오는 신호 x

w이 곱해지고

일정한 기준을 넘어가면 1로 나가고 아니면 0으로 나간다

이런 기계를 하드웨어로 만들었다

이런식으로,,,

특정한 input값에 대해 출력을 낸다

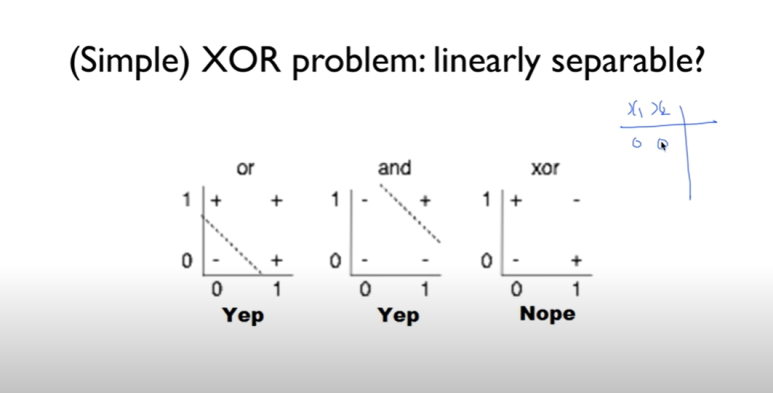

and 와 or을 예측할 수 있게 할 수 있을까?

할 수 있을 것같다. 그러면 XOR은?

xor은 값이 다를 때 1이 된다.

기계를 만들어서 이 xor를 하려고 하는데 잘 안된다

linear하게 선을 그어도 정확도가 50프로 밖에 안된다.

한 교수가 69년도에 책을 냈는데 XOR은 지금 가지고 있는 걸로는 풀수 없다고 증명을 했다

이런 레이어에서 아무도 못한다!

나중에 가서야 할 수 있는 방법이 나옴

네트워크가 연결되어 있고 wb를 가지고 값을 출력할 수 있다.

그래서 Backpropagation은 뒤에서 error를 구해서 다시 반대 방향으로 진행 시켜나가면 어떨까. 하는 생각이었다. 단순한 알고리즘이라고 한다.

결과적으로 더 복잡한 예측이 가능해짐

한 교수는 다른 방법으로 접근했다.

고양이한테 그림을 보게하고 고양이의 시신경 뉴런을 봤는데

일부의 부분부분만 활성화 된다는 걸 발견

우리가 그림을 볼때 동시에 전체를 보는게 아니라 일부를 보는 신경망들이 있고 그게 합쳐지는게 아닐까 라는 생각

그래서 Convolutional Neural Network 개발

부분부분을 잘라서 나중에 합치는 방법

알파고도 이 방법을 사용했다고 한다

90프로 이상의 성능을 보인다

(숫자, 글자를 읽는데에...)

근데 큰문제를 마주치게 된다

앞에 있는 error를 뒤로 다시 보낼때 의미가 갈수록 약해져서 뒤쪽으로 가서는 error가 전달이 안되는 경우가 생김

많이 할수록(deep한 신경망일수록) 성능이 떨어진다는 거다

2006년도 논문에서는 초기값을 잘 준다면 학습할 수 있다는 걸 보여줬다.

깊게 신경망을 구축하면 복잡한 문제를 풀 수 있다는 것도.

그리고 이름도 deep learning으로 바꾸었다

사람들이 이때부터 다시 관심을 가지고 연구하기 시작